Studentische Arbeiten

Die folgende Aufstellung gibt einen Überblick über Angebotene und Abgeschlossene Bachelor-, Master-, Studien- und Diplomarbeiten im Welfenlab.

Sollten Sie sich für eines der ausgeschriebenen Themen interessieren, oder haben Sie Interesse an einem ähnlichen Thema, so nehmen Sie bitte Kontakt mit Maximilian Klein auf.

Anzeigen:

- Alle Arbeiten

- Bachelorarbeiten

- Masterarbeiten

- Diplomarbeiten

- Studienarbeiten

- Seminararbeiten

Angebote

|

Bachelorarbeit

Intraoperative Erfassung der Beckenkippung mittels Handy-Sensoren

Ziel dieser Arbeit ist es, die Sensoren eines aktuellen (Highclass-)Handys möglichst optimal zu kombinieren, um die Winkelmessung in allen drei Achsen möglichst präzise durchführen zu können. Darüber hinaus soll eine App programmiert werden, die es dem Anwender die Ausrichtung der Beckeneingangsebene sowohl im stehen als auch im liegen zu erfassen. Die Winkelwerte können gespeichert und verglichen werden. So wird eine Kippung des Beckens sichtbar. Wird anschließend noch die Ausrichtung des anatomischen Acetabulum im Becken erfasst, stehen alle zur Implanation eines Pfannenimplantats gewünschten Informationen zur Verfügung.

Betreuer: Daniel Brandes |

In Bearbeitung

|

Bachelorarbeit

Karl Hasselbring

Hochperformante Datenstrukturen für persistente Compound Graphen

Beschreibungstext anzeigen

Im Rahmen meiner Forschung an dem Code-Generierungs-Tool Buggy werden spezielle Compound-Graphen verwendet, die neben der Graphstruktur auch noch eine Hierarchie aufbauen. Diese wird durch Compound Knoten realisiert. Dies sind Knoten die selber wieder Graphen enthalten können. Dazu gibt es mehrere Layer von Kanten die entweder über spezifische Ports verbunden sind oder aber Knoten direkt verbinden. Die Graph Implementierung (zu finden unter https://github.com/BuggyOrg/graphtools) hat dafür einige Anfrage-Möglichkeiten die das Arbeiten mit den Graphen erleichtern soll. Die ganzen Operationen sind dafür persistent implementiert, das heißt nach außen hin scheinen die Graphen immutable zu sein. Dies hat für uns den Vorteil, dass Operationen leicht nachvollziehbar bleiben und Fehler meist einfach zu identifizieren sind. Zum sicherstellen der immutability werden momentan alle Graphen für jede Operation kopiert. Dies ist sehr aufwändig und kann eindeutig verbessert werden. Ziel dieser Bachelorarbeit ist das Entwickeln von Algorithmen zum effizienten Bearbeiten und Anfragen in oben vorgestellten Compound Graphen. Dazu sollen existierende Verfahren zum Erzeugen von effizienten persistenten Datenstrukturen evaluiert werden und an die Bedürfnisse des existierenden Graphen angepasst werden. Betreuer: Maximilian Klein April 2017

|

|

Bachelorarbeit

Elias Entrup

Emergente Array-Typisierungen in algebraischen Datentypen

Beschreibungstext anzeigen

Algebraische Datentypen schaffen sind eine elegante Beschreibung von Datentypen, die stark das Konzept rekursiver Definitionen ausnutzen. Algorithmen, die solche Datentypen verwenden ähneln in der Struktur stark der Datenstrukturdefinition und führen so zu meistens gut nachvollziehbaren Code. Die Umsetzung solcher algebraischer Datentypen in ausführbaren Programmen ist direkt ableitbar aus deren Definition und basiert meist aus verlinkten Strukturen. Genau diese Interpretation der Datenstrukturen (als verlinkte Strukturen) führt jedoch häufig zu schlechteren Laufzeiten. Das dereferenzieren von Pointern ist eine teure Operation, da diese den Cache einer CPU nicht ausnutzen kann. Um die elegante Struktur von algebraischen Datentypen zu erhalten und dennoch performante Programme erzeugen zu können, wäre eine Analyse der Datenstruktur denkbar, die versucht die verlinkten Strukturen durch Arrays zu ersetzen (wo möglich). Diese Bachelorarbeit soll genau solche Fälle untersuchen und das Optimierungspotential von Ersetzungssystemen analysieren. Betreuer: Maximilian Klein April 2017

|

Abgeschlossen

| 2017 | ||||||

|

Bachelorarbeit

Tim Ebbeke

Automatisierte Typ Spezialisierungen

Beschreibungstext anzeigen

Am Welfenlab wird gerade eine Datenflussbasiertes System (Buggy) entwickelt das unter anderem das Ziel verfolgt das manuelle Optimieren von Code zu automatisieren. Ein Teil dieses Problems ist die Optimierung der Datentypen, die in einem Programm verwendet werden. Z.B. sind Ganzzahloperationen schneller als Floating-Point Operationen. Oft wird deswegen der Datentyp int verwendet, auch wenn ein Floating-Point Typ genau die selben Ergebnisse liefern würde. Die Entscheidung welcher Typ wann am geeignetsten ist wird üblicherweise intuitiv vom Programmierer getroffen. In dieser Arbeit soll dieser intuitive Entscheidungsprozess analysieret werden und im existierenden Buggy-System algorithmisch eine automatisierte Typentscheidung implementiert werden die zunächst Datentypen wie double und int gegeneinander abwägt. Denkbar wären auch kompliziertere Typentscheidungen wie z.B. SIMD Typen oder ähnliches. Betreuer: Maximilian Klein November 2016

März 2017

|

||||||

| 2016 | ||||||

|

Bachelorarbeit

Maik Marschner

Optimierung von Kontrollflussgraphen mit Graphersetzungssystemen

Beschreibungstext anzeigen

Die Optimierung von Programmen geschieht auf verschiedenen Abstraktionsebenen: Einerseits bei der Wahl des passenden Algorithmus, andererseits durch Transformationen des Programmquellcodes. Werden Transformationen angewandt so müssen diese ein äquivalentes Programm induzieren. Dies wird üblicherweise erreicht indem der Kontrollflussgraph des Programmes berechnet wird. In einem Kontrollflussgraphen sind alle Abhängigkeiten explizit gegeben wodurch äquivalente Programmtransformationen einfacher angegeben werden können. In den meisten Programmiersprachen wird dafür ein approximativer Kontrollflussgraph aus dem Programmquellcode berechnet.In dieser Arbeit wird ein Framework zum Erstellen und Anwenden von Graphersetzungssystemen erstellt, dass Programme die mit dem am Institut entwickelten System "Buggy" geschrieben sind, optimieren soll. Diese haben den Vorteil, dass der Kontrollflussgraph explizit und vollständig gegeben ist und überdies eine hierarchische Struktur vorhanden ist, die auch Optimierungen auf höheren Abstraktionsebenen ermöglichen können. Betreuer: Maximilian Klein April 2016

August 2016

|

||||||

|

Bachelorarbeit

Jannik Bertram

Semantische Abstraktion von Programmiermodellen

Beschreibungstext anzeigen

In der Bachelorarbeit wird eine Prozedur ausgearbeitet, die Probleme, welche auf gegebenen Daten eines bestimmten Datentyps formuliert sind, verschiedene Lösungsfunktionen auswählen kann. Der Benutzer definiert im Idealfall lediglich das Problem und übergibt eine optionale Menge an Eigenschaften, die von der zu verwendenden Funktion erfüllt sein sollen. Das zugrunde liegende System soll dann mit Hilfe der drei Komponenten Eingabedaten, Problemstellung und den zu erfüllenden Eigenschaften eine Entscheidung treffen können, welcher Algorithmus für das Problem am sinnvollsten anzuwenden ist. Die Entscheidungsfindung wird dafür in eine statische Komponente (zur Erzeugung des Programmes) und eine dynamische Komponente (beim Ausführen des Programmes) unterteilt werden. Betreuer: Maximilian Klein April 2016

August 2016

|

||||||

|

Bachelorarbeit

Thilo Schulz

Leibniz Universität Hannover

Entwurf und Implementierung eines Reeb Graph Analyse Moduls für die Segmentnachbearbeitung

Beschreibungstext anzeigen

In der modernen Medizin fallen heutzutage routinemäßig große Mengen an tomographischen Daten an. Neben der Datenhaltung an sich ist die Segmentierung, d.h. die Merkmalsextraktion, eines der wichtigsten Themen. Besonders für schwer zu klassifizierende traumatische Veränderungen (bspw. Trümerbruch) lassen sich in der Regel keine modellbasierte Verfahren verwenden. Hier muss auf allgemeine Verfahren zurückgegriffen werden, die in der richtigen Kombination eine gute Approximation der gewünschten Struktur liefern. Oft kommt es jedoch zu unerwünschten Übergängen, d.h. die eigentliche Struktur ist durch eine auflösungsbedingte Ungenauigkeit über eine (dünne) Verbindung mit weiteren Strukturen verbunden. Um diese zu identifizieren, haben sich das Konzept des Reeb Graph als nützlich erwiesen. Dabei wird schichtweise nach Zusammenhangskomponenten gesucht und diese mit ihren Verbindungen zu Komponenten in den benachbarten Schichten in einer Graph Struktur abgelegt. Betreuer: [email protected] Januar 2016

Mai 2016

|

||||||

|

Bachelorarbeit

Yannic Rath

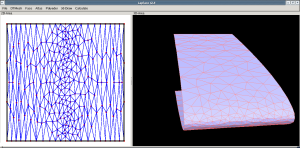

Verlässliches Quad-Remeshing

Beschreibungstext anzeigen

Insbesondere durch ihre vielseitige Verwendbarkeit kommen Vierecksgittern eine zunehmend größere Bedeutung zu. Die Visualisierung von 3D-Objekten mithilfe von Vierecken ist zum einen optisch deutlich ansprechender als die Darstellung mit „herkömmlichen“ Dreiecksgittern und zum anderen bieten sie meist eine bessere Grundlage für weiterführende Anwendungen wie z. B. Texturierung. Nichtsdestotrotz ist die Berechnung dieser Gitter durchaus kompliziert. Während Dreiecksgitter einfach durch Algorithmen wie die Delaunay-Triangulation erzeugt werden können, sind die meisten aktuellen Algorithmen für Vierecksgitter, insbesondere in Bezug auf Effizienz und Verlässlichkeit, verhältnismäßig eingeschränkt. Unser Hauptziel ist es daher einen neuen Quad-Remeshing-Algorithmus zu implementieren, welcher aus einem gegebenen Dreiecksnetz ein Vierecksgitter erzeugt. Um dies zu erreichen werden wir einen Parametrisierungs-Ansatz verwenden, d. h. das kartesische Netzgitter soll mithilfe einer globalen Parametrisierung auf die Oberfläche projiziert werden. Dies lässt sich auf ein gemischt-ganzzahliges Optimierungsproblem zurückführen, welches effektiv und zuverlässig durch Anwendung verschiedener Komplexitätsreduktionen und Ausnutzen weiterer Zwangsbedingungen gelöst werden kann. Wir werden diese auf aktuellen Publikationen basierende Methode im Hinblick auf Verlässlichkeit und Effizienz untersuchen, um ihre Stärken und Schwächen herauszustellen. Hiermit werden wir versuchen weitere Optimierungen zu entwickeln, um einen allgemeineren Quad-Remeshing Algorithmus zu erstellen, welcher „echte“ Vierecksgitter effizient und verlässlich erzeugt. Betreuer: Daniel Brandes Dezember 2015

April 2016

|

||||||

|

Bachelorarbeit

Frederik Nörmann

Interaktive Code Abstraktionen

Beschreibungstext anzeigen

Beim Schreiben von Code entstehen häufig Situationen in denen die verwendete Programmiersprache nicht optimal geeignet ist um den jeweiligen Sachverhalt darzustellen. Insbesondere graphische Repräsentationen des zugrundeliegenden Problems könnten beim Lesen des Codes oft hilfreich sein. Modernere Entwicklungsumgebungen sind so vielseitig, dass das Einbinden von graphischen Elementen kein Problem wäre. Dennoch gibt es nicht einmal die Möglichkeit in Kommentaren graphische Elemente einbinden zu können. Interaktive Elemente sind noch weniger verbreitet.Diese Arbeit beschäftigt sich mit der Entwicklung eines Editor-Plugins (für Atom), welches es zunächst ermöglichen soll graphische Elemente in Editoren einbinden zu können. Darauf aufbauend soll eine Abstraktion von gewissen Code Elementen durch grafische Bausteine ermöglicht werden. Z.B. Bezier Splines über entsprechende graphischen Interfaces eingegeben. Betreuer: Maximilian Klein November 2015

März 2016

|

||||||

| 2015 | ||||||

|

Bachelorarbeit

Lorenz Dames

Leibniz Universität Hannover

Codegenerierung für symbolische Mathematik

Beschreibungstext anzeigen

Probleme in der Differentialgeometrie oder Finiten Elemente Methode erfordern häufig die Umsetzung komplexer mathematischer Zusammenhänge in einer mehr oder weniger dafür geeigneten Programmiersprache. Häufige Anwendungen sind unter anderem die automatische Bestimmung von Ableitungen, numerische Integration und die Aufstellung symbolischer Matrizen. Betreuer: Rasmus Buchmann Mai 2015

September 2015

|

||||||

|

Bachelorarbeit

Sebastian Veitleder

Thin Shell Simulation der Basilarmembran

Beschreibungstext anzeigen

This work is researching the response of the basilar membrane of the human cochlear to different stimuli from the scala tympani. A triangle mesh of the basilar membrane is used to produce a shell model. On this model a three-dimensional thin shell simulation is performed by using a modified cloth simulator that accounts for flexural energy over the mesh edges. The force that the scala tympani would induce on the basilar membrane is directly applied to the simulated model. A Lattice-Boltzman fluid simulation generates reasonable forces to apply to the model and observe. Several examples show the validity of the simulation. Betreuer: Maximilian Klein Mai 2015

September 2015

|

||||||

|

Bachelorarbeit

Hermann Kroll

Leibniz Universität Hannover

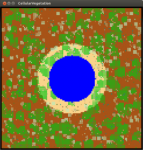

Erkennung der Substrukturen des Acetabulum in 3D-Pelvis Modellen

Beschreibungstext anzeigen

Für die Planung von Hüftoperationen ist eine genaue Analyse der patientenindividuellen Geometrie erforderlich. Dabei ist vor allem die Oberflächenstruktur der Hüftpfanne (Acetabulum) als Kontaktregion zum Femurkopf von besonderem Interesse. Betreuer: Karl-Ingo Friese Mai 2015

September 2015

|

||||||

|

Bachelorarbeit

Jakob Riga

Leibniz Universität Hannover

Entwurf und Entwicklung einer haptischen Eingabemethode zur Erfassen von Metainformationen auf 3D-Oberflächen

Beschreibungstext anzeigen

In klinischen Prozessen spielt die tomographische Bildgewinnung heutzutage eine immer größere Rolle. Die dabei gewonnen Schichtbilddaten sind jedoch nur der erste Schritt eines komplexen Verarbeitungsprozesses. Eine auch heute noch schwierige Aufgabe ist die sogenannte Segmentierung, bei der bestimmte Substrukturen (Organe, Knochen, ...) identifiziert werden. Als besonders vielversprechend haben sich dabei Algorithmen gezeigt, die anwendungsspezifisches Modellwissen mit einbeziehen (modelbasierte Segmentierung). Betreuer: Karl-Ingo Friese Juli 2015

September 2015

|

||||||

|

Bachelorarbeit

Stephan Singer

Leibniz Universität Hannover

Vergleich von SIFT und einer neuen HKS-Methode zur Bildanalyse

Beschreibungstext anzeigen

Um Bilder auf Ähnlichkeit zu vergleichen, kann man aus den Umgebungen ausgewählter Punkte Featuredeskriptoren extrahieren und anschließend diese vergleichen. Ein etabliertes Verfahren dazu ist SIFT (Scale invariant feature transform). Zum Vergleich von 3D-Formen gibt es als Featuredeskriptoren di sogenannten Heat Kernel Signatures, die die geometrische Umgebung eines Punktes dadurch beschreiben, wie er abkühlen würde, wenn man ihn erhitzt. Mittels am Welfenlab entwickelter bildabhängig modifizierter Laplaceoperatoren kann ein Analogen der Wärmeleitungsgleichung auch für Bilddaten aufgestellt und so eine HKS für Punkte in Bildern definiert werden. In der Bachelorarbeit werden SIFT und HKS für Bilder miteinander verglichen. Betreuer: Benjamin Berger Juni 2015

September 2015

|

||||||

|

Bachelorarbeit

Alexander Treptau

Cochleasimulation mit dem Lattice Boltzmann Verfahren

Beschreibungstext anzeigen

Die Cochlea ist der Teil des Innenohrs, der für die Aufnahme der auditiven Reize zuständig ist. Dabei breitet sich eine Schallwelle in einem Fluid aus und versetzt die Membran des Corti-Organs in Bewegung, sodass diese die mechanischen Schwingungen in Nervenimpulse umwandeln kann. Bei dem Lattice Boltzmann Verfahren wird ein Fluid mithilfe eines zellulären Automaten auf Teilchenebene diskretisiert. Unter Verwendung dieses Verfahrens kombiniert mit der Immersed Boundary Methode wird die Mechanik einer zweidimensionalen Cochlea modelliert und analysiert. Dabei soll insbesondere die Lokalisierung der eingehenden Schallwellen durch das ovale Fenster auf der Basilarmembran nachgebildet werden und mit den Ergebnissen von u.a. Gerstenberger et al 2013 verglichen werden. Betreuer: Maximilian Klein April 2015

August 2015

|

||||||

|

Bachelorarbeit

Thomas Winter

Die Immersed Boundary Methode für das Lattice Boltzmann Verfahren

Beschreibungstext anzeigen

In dieser Arbeit wird das Zusammenspiel der Lattice Boltzmann Methode mit dem Immersed Boundary Verfahren untersucht. Das Lattice Boltzmann Verfahren ist ein gribbasierter Fluid Löser der mit relativ einfachen lokalen Regeln die Boltzmanngleichung lösen kann. Um nun komplexe Geometrien die nicht am Gitter ausgerichtete sind zu unterstüzen soll das Immersed Boundary Verfahren verwendet werden. Dieses ermöglicht es Obejkte die physikalisch nicht auf dem Gitter simuliert werden mit dem Fluid zu koppeln. So können die Vorteile der Lattice Boltzmann Methode ausgenutzt werden (z.B. die hervoragende Parallelisierbarkeit) ohne dabei auf Modelle in Lagranger Sicht verzichten zu müssen. In dieser Arbeit wird dafür eine stabile Kopplung verschiedener Systeme mit dem Immersed Boundary Verfahren vorgestellt und soweit möglich mit Literaturwerten verglichen. Betreuer: Maximilian Klein November 2014

März 2015

|

||||||

|

Bachelorarbeit

Ferdinand Lange

Visualisierung von 3D Fluiden

Beschreibungstext anzeigen

Bei der Visualisierung von Fluiden in drei Dimensionen müssen viele Daten in verständlicher Form dargestellt werden. Da die große Menge an verschiedenen Daten in einer Grafik meist kompliziert und nicht unbedingt verständlich ist, beschäftigt sich diese Arbeit mit Möglichkeiten Fluide in drei Dimensionen anschaulich zu visualisieren. Um Fluide zu Visualisieren müssen grundsätzlich zwei Arten von Felder dargestellt werden können. Einmal skalare Felder wie z.B. der Druck oder die Dichte, andererseits Vektor Felder wie die Geschwindigkeit. Problematisch ist dabei oft die Überdeckung von Details die inmitten des beobachteten Volumens liegen. Dafür soll diese Bachelorarbeit Möglichkeiten schaffen Felder darzustellen und geeignet filtern zu können um spezifierte Regionen einzublenden und andere auszublenden. Betreuer: Maximilian Klein November 2014

März 2015

|

||||||

|

Bachelorarbeit

Sven Gesper

Mensch-Maschine-Kommunikation

Untersuchungen zur Parallelisierbarkeit von auf stochastischen Suchverfahren basierenden asynchronen variationellen Integratoren

Beschreibungstext anzeigen

In dem Projekt "Tactil Displays for Virtual Reality Applications" wird mittels einer FEM-Simulation, die sich auf Asynchrone Variationelle Integration (AVI) stützt, der Kontakt eines Fingers mit einer Oberfläche simuliert. Da jedes Element in einem individuellen Zeitschritt berechnet wird, muss ein Algorithmus darüber wachen, dass die gesamte Simulation zeitlich möglichst kontinuierlich abläuft und keine zu großen Abstände zwischen den Elementen herrschen. Eine hohe Geschwindigkeit kann durch Parallelisierung der Simulation erreicht werden. Die Reihenfolge der Berechnung der AVI-Elemente wird durch einen Algorithmus ermittelt, der hinsichtlich seiner Parallelisierbarkeit durch unterschiedliche Kollisionsbehandlungen untersucht wird. Die Anzahl der Kollisionen sowie der gleichmäßig Fortschritt in der Zeit sind zu optimierende Aspekte. Betreuer: Daniel Brandes September 2014

Januar 2015

|

||||||

| 2014 | ||||||

|

Bachelorarbeit

Felix Schliephacke

Gebietszerlegung für die Lattice Boltzmann Methode auf verteilten Speicherarchitekturen

Beschreibungstext anzeigen

Das Lattice Boltzmann Verfahren ist ein Verfahren das die Boltzmanngleichung lösen kann, welches auf einem regulären Gitter mittels einfacher Evolutionsregeln, ähnlich derer eines Zellulären Automatens, arbeitet. Bei der Implementierung einer verteilten Simulation sind insbesondere die Latenzen ein den Speedup begrezender Faktor. Die Latenzen entstehen dabei hauptsächlich durch den Abgleich der Randbereiche. Deswegen versucht man beim Erstellen der einzelnen Subdomains die Randbereiche so klein wie möglich zu halten, dabei soll jedoch das Innere so groß wie möglich bleiben. Ziel dieser Arbeit ist es eine möglichst optimale Zerlegung einer Domäne in Teilbereiche zu finden. Dazu sind insbesondere die Rechengeschwindigkeit der einzelnen Rechner und die Geschwindigkeit der einzelnen Netzwerkverbindungen zu beachten. Betreuer: Maximilian Klein Mai 2014

Oktober 2014

|

||||||

|

Bachelorarbeit

Jan Jamaszyk

Leibniz Universität Hannover

Übertragungsfunktion für die Mechanik der Fingerspitze

Beschreibungstext anzeigen

Eine Wahrnehmung der „virtuellen Welt“ beschränkt sich aktuell größtenteils auf den optischen, sowie den akustischen Sinn. Um realistische Sinneseindrücke zu vermitteln wäre eine Verwendung des taktilen Sinnes wünschenswert. Im Rahmen dieser Arbeit soll eine Übertragungsfunktion entwickelt werden, die den Zusammenhang zwischen mechanischer Kraft des Aktuators und entsprechenden Stressmaßen am Rezeptor, basierend auf den Daten einer Finite-Elemente Simulation, beschreibt. Mittels Inversion dieser Funktion sollen so später optimale Anregungen der Aktuatoren gefunden werden, die den Eindruck realer Oberflächen möglichst detailgetreu abbilden. Betreuer: Rasmus Buchmann, Alexander Vais Betreuer: Rasmus Buchmann Juni 2014

Oktober 2014

|

||||||

|

Bachelorarbeit

Nils Hein

Leibniz Universität Hannover

Strukturerhaltende Fluidsimulation

Beschreibungstext anzeigen

Visuelle Qualität und kurze Berechnungszeiten sind wichtige Eigenschaften einer Fluidsimulation, die erreicht werden müssen ohne die Stabilität der Simulation zu beeinträchtigen. Häufig verwendete Methoden wie "Stable Fluids" oder "Smoothed Particle Hydrodynamics" sind nicht ausreichend um die Vortizität eines Fluids ausreichend abzubilden. Diese Arbeit implementiert daher ein auf dem sog. "Discrete Exterior Calculus" basierendes Framework, dass die physikalischen Größen als diskrete Differentialformen modelliert und die zeitliche Entwicklung des Fluids über einen geometrisch motivierten Integrationsalgorithmus berechnet. Betreuer: Rasmus Buchmann Juni 2014

Oktober 2014

|

||||||

|

Bachelorarbeit

Falk-David Deppe

Institut für Mensch-Maschine-Kommunikation

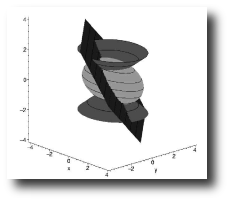

Zeitadaptive asynchrone Textilsimulation

Beschreibungstext anzeigen

In dieser Arbeit soll eine Textilsimulation mit einem einfachen Kontaktmodell implementiert werden, die sich an der haptischen Textilsimulation des HAPTEX Projektes orientiert. Einer der wesentlichen Anforderungen an die Simulation ist daher eine hohe Simulationsgeschwindigkeit, um die für haptisches Empfinden benötigten 1000Hz im Kontaktbereich erreichen zu können. Im Gegensatz zu dem vorangegangenem HAPTEX-Projekt soll ein FEM basierender Algorithmus implementiert werden, der sich auf die sog. Asynchrone Variationelle Integration (AVI) stützt. Dieser Ansatz hat den Vorteil, jedes Element mit einen individuellen Zeitschritt berechnen zu können. In dieser Arbeit soll nun untersucht werden, inwiefern es möglich ist, mit einem zeitadaptiven Ansatz die o.g. Anforderungen an die haptische Echtzeit zu erfüllen. Betreuer: Andreas Tarnowsky Mai 2014

Oktober 2014

|

||||||

|

Bachelorarbeit

Sven Feldkord

Institut für Mensch-Maschine-Kommunikation

A scalable controller for operating multidirectional tactile arrays

Beschreibungstext anzeigen

In dem durch die DFG geförderten Projekt "Tactile Displays for Virtual-Reality-Applications" wird in Kooperation mit dem Institut für Dynamik und Schwingungen (IDS) und dem Institut für Mikroproduktionstechnik (IMPT) ein sog. taktiles Display entwickelt, welches in der Lage ist, den Wahrnehmungseindruck real existierender Oberflächen auf einem Array von beweglichen Stiften nachzubilden. Am Institut für Mensch-Maschine-Kommunikation wird zur Zeit ein Modell entwickelt, welches die für die Erzeugung dieses taktilen Eindrucks notwendigen Parameter in Form von zeitlich variablen diskreten Frequenzspektren auf Basis gegebener Oberflächenparameter bestimmt. Ziel dieser Arbeit ist es, eine Hardwareeinheit zu konzipieren und zu realisieren, welche die durch das Modell gegebenen diskreten Frequenzspektren in ein kontinuierliches Signal umsetzt, welches zur Ansteuerung des taktilen Displays verwendet werden kann. Wesentliche Anforderungen an dieser Hardwareeinheit sind neben einer hohe Qualität des Ausgangssignals auch eine einfache Möglichkeit der Skalierung auf größere Displays. Betreuer: Andreas Tarnowsky Mai 2014

Oktober 2014

|

||||||

|

Bachelorarbeit

Jurek Leonhardt

Automatische Erkennung des Acetabulum in 3D-Pelvis Modellen

Beschreibungstext anzeigen

Hüftimplantate zählen zu den häufigsten orthopädischen Operationen. Für eine patientenindividuelle Planung von Implantat und Eingriff ist es notwendig, sowohl die Hüfte (Pelvis) als auch den Oberschenkelknochen (Femur) zu identifizieren. Von besonderem Interesse ist dabei die Kontaktregion, die aus dem Kopf des Femur (caput ossis femoris) und der Hüftpfanne (acetabulum) besteht.

Ziel dieser Arbeit ist es, das Acetabulum in gegebenen 3D-Pelvis Modellen zu identifizieren. Dafür sollen unterschiedliche Algorithmen untersucht, implementiert und verglichen werden. Betreuer: Karl-Ingo Friese Mai 2014

September 2014

|

||||||

|

Bachelorarbeit

Thilo Schnelle

Fluidsimulation mit dem Lattice Boltzmann Verfahren

Beschreibungstext anzeigen

In dieser Arbeit soll eine Fluidsimulation mit der Lattice Boltzmann Methode implementiert werden. Diese Methode diskretisiert das Fluid mit zellulären Automaten und erreicht dadurch eine hohe Parallelität. Teil dieser Arbeit ist die Beschreibung der Diskretisierung, die im Lattice Boltzmann Verfahren angewandt wird. Zusätzlich dazu soll das Verfahren implementiert werden und anhand üblicher Beispiele wie dem "Lid-Driven-Cavity-Flow" Beispiel mit bekannten Lösungsverfahren verglichen werden. Dabei sind insbesondere die Konvergenzraten, Parallelität, Einhaltung der Inkompressibilitätsbedingung und die Interaktion mit Objekten von Interesse. Betreuer: Maximilian Klein Mai 2014

September 2014

|

||||||

|

Bachelorarbeit

Wolff Bock von Wülfingen

Das Lattice Boltzmann Verfahren für Cluster Architekturen

Beschreibungstext anzeigen

Diese Arbeit befasst sich mit der Parallelisierung des Lattice Boltzmann Verfahrens. Das Lattice Boltzmann Verfahren löst die Boltzmanngleichung über eine reguläre Diskretisierung und verwendet Regeln ähnlich der von Zellulären Automaten. Diese Formulierung hat den großen Vorteil, dass sie lokal arbeitet und somit leicht parallelisierbar ist. In dieser Arbeit wird neben der Shared-Memory Parallelisierung auch die Parallelisierung auf ein Clustersystem untersucht. Dazu wird ein Protokoll zur Kommunikations der einzelnen Rechner entwickelt welches möglichst gut Latenzen überdecken soll. Betreuer: Maximilian Klein April 2014

August 2014

|

||||||

|

Bachelorarbeit

Adrian Hengelhaupt

Mensch-Maschine-Kommunikation

Adaptive 3D-Visualization of fractal Heightmaps using Tessellation Shaders

Beschreibungstext anzeigen

Das Institut für Mensch-Maschine-Kommunikation verfügt über vielfältige Visualisierungs- und Interaktionssysteme für Virtual-Reality Applikationen. Als Demonstrationsanwendung soll eine Interaktive 3D-Umgebung geschaffen werden, die fortgeschrittene 3D-Visualisierung, haptische Interaktion und physikalische Simulation beinhaltet.

Ziel dieser Arbeit ist es, existierende Algorithmen zur Generierung von fraktalen Höhenkarten einzusetzen, um virtuell erkundbare Landschaften in Echtzeit dreidimensional visualisieren zu können. Um eine jederzeit flüssige und zugleich qualitativ hochwertige Darstellung zu garantieren, soll eine adaptive Verfeinerung eines Basismeshes durch einen Tessellation-Shader realisiert werden. Als Kriterium für die Verfeinerung können beispielsweise Gradienteninformationen der Höhenkarte ausgewertet werden.

Die Programmierung erfolgt in C++ und OpenGL. Als Basis für die Implementierung dient das aus dem Labor "Grafikprogrammierung" bekannte auf Qt basierende GDV-Framework. Betreuer: Andreas Tarnowsky November 2013

März 2014

|

||||||

| 2013 | ||||||

|

Bachelorarbeit

Markus Schulze

Haptisches Heightfieldwater

Beschreibungstext anzeigen

Diese Arbeit befasst sich mit einem einfachen Wassermodell, das in der einfachsten Form nur aus Höhendaten besteht. Die Simulation eines solchen Wassers erweist sich als äußerst effizient, jedoch können einige Eigenschaften des Wassers nicht abgebildet werden. Für dieses sogenannte Heightfieldwater gibt es zahlreiche Publikationen über das Zusammenspiel mit starren Körpern. Diese erlauben es die Kräfte auf die Objekte realistisch zu berechnen.

Zusätzlich existieren am Institut haptische Eingabegeräte die es erlauben Kräfte auszugeben. Für eine natürliche Interaktion sind dafür hohe Wiederholraten (am besten 1000Hz) erfordertlich. Dies lässt sich nur über eine gescheite Wahl der Modelle realisieren. Im Bereich der Wassersimulation gilt das Heightfieldwater als am wenigsten aufwändig und ist deswegen ein interessanter Kandidat für eine haptische Interaktion.

In dieser Arbeit soll primär die Interaktion mit dem Wasser implementiert werden. Für die Interaktion der Körper untereinander soll Bullet verwendet werden.

Beschreibungstext verbergen

Betreuer: Maximilian Klein Mai 2013

September 2013

|

||||||

|

Bachelorarbeit

Volker Schmidt

Über den Einfluss von Kompressionen auf das paralle superkonvergente Multigrid Verfahren

Beschreibungstext anzeigen

Das Multigrid Verfahren ist eines der performantesten Verfahren zum Lösen von Linearen Gleichungssystemen. Insbesondere für physikalische Probleme hat sich das das Multigrid Verfahren bewährt [1].

Für das Multigrid Verfahren existieren einige Parallelisierungsmöglichkeiten. Der Großteil setzt dabei jedoch an den Lösern für die linearen Gleichungssysteme an, die auch Smoother genannt werden. Ein ganz anderen Ansatz verfolgt das PSMG (parallele superkonvergente Multigrid) Verfahren [2]. Das Multigrid Verfahren versucht die Lösung im feinen Grid durch eine grobe Approximation des Fehlers auszugleichen und damit die Konvergenz zu beschleunigen. Für das Erstellen des groben Problems gibt es mehrere Möglichkeiten von denen üblicherweise eine gewählt wird. Im PSMG werden dahingegen alle Möglichkeiten gewählt und all diese werden parallel gelöst. Das PSMG Verfahren besitzt eine deutlich höhere Konvergenzrate als herkömmliche Verfahren jedoch erfordert sie auch einen größeren Kommunikationsoverhead.

Ziel dieser Arbeit soll es sein, den Poisson Solver einer Fluid Simulation, zum Berechnen des Druckausgleiches, mittels PSMG zu realisieren. Dabei soll untersucht werden, ob Kompressionsalgorithmen den Kommunikationsaufwand signifikant zu verringern können.

Beschreibungstext verbergen

Betreuer: Maximilian Klein Juni 2013

August 2013

|

||||||

|

Bachelorarbeit

Roman Zimbelmann

Haptisches Modellieren

Beschreibungstext anzeigen

In dieser Arbeit soll ein haptisches Gerät (z.B. das Phantom) verwendet werden um ein haptische Virtual Clay Simulation zu entwickeln. Das haptische Gerät soll einem dabei die Möglichkeit geben ein virtuelles Objekt zu verformen und vielleicht auch topologisch zu ändern, um so verschiedenste Modelle fertigen zu können. Dazu sollen verschiedene Werkzeuge angeboten werden, die einem das Modellieren erleichtern sollen. Es soll zunächst recherchiert werden ob Mesh-based, Voxel-based oder gemischte Verfahren am besten geeignet für die haptische Interaktionen sind . Die große Herausforderung steckt dabei im Erreichen der haptischen Echtzeit, die 1000 fps benötigt. Technisch kann dieses über lokal-adaptive Verfahren erreicht werden. Ein Teil dieser Arbeit wird sein, die vorhandene Netzwerkschnittstelle für die haptischen Geräte zu vervollständigen. Eine Bachelorarbeit / Studienarbeit mit geringerem Umfang ist auch denkbar. Betreuer: Maximilian Klein November 2012

März 2013

|

||||||

|

Bachelorarbeit

Sven Röttering

Vegetationsgenerierung mittels Zellulärer Automaten und Spieltheorie

Beschreibungstext anzeigen

Der am Institut entwickelte prozedurale Planetengenerator kann Terrain-Daten für einen Planeten mit verschiedenen klimatischen Zonen aus einem einzelnem Seed erzeugen. Der daraus resultierende Planet verfügt jedoch noch über keine Vegetation. Ein manuelles setzen der Vegetation ist nicht nur aufwändig, sondern führt auch zu unrealistische wirkenden Regionen. Deshalb soll in dieser Arbeit ein System entworfen werden, welches eine Vegetation für einen zufällig generierten Planeten erzeugt und auch visualisiert. Technisch soll die Vegetation durch einen Zellulären Automaten unter Zuhilfenahme von spieltheoretischen Modellen erzeugt werden. Dazu muss ein Basisdatensatz an Vegetationsobjekten wie Bäumen, Kakteen, Sträuchern, etc. erzeugt werden und geeignet kategorisiert werden. Unter Zuhilfenahme dieses Datensatzes soll auf der Oberfläche ein Zellulärer Automat simuliert werden, dessen Regeln sich aus dem spieltheoretischen Modell und den klimatischen Gegebenheiten ableiten. Betreuer: Maximilian Klein Oktober 2012

Februar 2013

|

||||||

| 2012 | ||||||

|

Bachelorarbeit

Peter Denis

Stereographische Visualisierung von 360° Aufnahmen auf einem Head Mounted Display (HMD)

Beschreibungstext anzeigen

Seit einiger Zeit sind Panoramafotos ein beliebtes Mittel zur Illustration von öffentlichen Plätzen oder Produkten geworden. Klassischerweise wird dabei eine normale Kamera rotiert und die dabei entstehenden Einzelaufnahmen zu einem großen Panorama zusammengefügt. Projiziert man dieses Panorambild zusätzlich auf eine zylindrische Geometrie, entsteht der Eindruck, als ob man sich in der Szene befindet.

Beschreibungstext verbergen

Betreuer: Karl-Ingo Friese Mai 2012

September 2012

|

||||||

|

Bachelorarbeit

Marc Lühr

Interaktive Szeneexploration mittels Datenhandschuh und optischem Tracking

Beschreibungstext anzeigen

Im alltäglichen Leben ist die Hand einer der wesentlichsten Werkzeuge um mit der umgebenden Welt zu interagieren. Diese Interaktionsmöglichkeit wird bei der Arbeit mit Computern nur unzureichend über eingaben via Tastatur und Maus umgesetzt. Besonders bei Interaktionen mit einer dreidimensionalen Welt sind diese limitierten Werkzeuge ein großes Hinderniss für eine intuitive Steuerung. Natürlicher wäre eine Steuerung die die Bewegung der Hände mit einbeziehen würde. Dazu soll in dieser Bachelorarbeit der CyberGlove 2 Datenhandschuh zur Exploration einer dreidimensionalen Szene verwendet werden. Die Fingerstellung wird dabei über Widerstandssensoren im Handschuh gemessen und kann so zur Darstellung des Handmodells verwendet werden. Die Informationen über die Lage der Hand im Raum soll anschließend, durch am Kopf befestigte Kameras und Marker auf der Hand, rekonstruiert werden. Diese Arbeit soll in ein plattformunabhängiges Java-Framework integriert werden, dass die Darstellung dreidimensionaler Szenen mittels eines Head-Mounted-Displays ermöglicht soll. Die Darstellung wird in der Bachelorarbiet "Stereographische Visualisierung von 360° Aufnahmen auf einem Head Mounted Display (HMD)" durch Peter Denis implementiert. Durch die stereoskopsiche Darstellung der Szene gepaart mit der Interaktion durch die Hand soll so eine hohe Immersion erreicht werden, die ein intuitives Arbeiten in der virtuellen Szene erlaubt. Betreuer: Karl-Ingo Friese Mai 2012

September 2012

|

||||||

|

Bachelorarbeit

Oliver Weidner

Implementation eines Echtzeitmodells für den Wasserkreislauf

Beschreibungstext anzeigen

Auf Basis der vorangegangen Bachelorarbeit "Prozedurale Multiskalen-Generierung von Planetenoberflächen" angefertigt von Felix Haase, soll in dieser Arbeit ein physikalisches Modell entwickelt werden, dass den Wasserkreislauf eines Planeten simuliert. Das Modell für den Wasserkreislauf arbeitet mit verschiedenen Schichten, die z.B. die Planetenoberfläche und die Atmosphäre darstellen. In diesen Schichten werden unterschiedliche Modelle simuliert, so soll für die Atmosphäre ein projiziertes SPH Fluid verwendet werden. Ziel dieser Arbeit ist die Implementierung einer interaktiven Simulation auf einer Planetenoberfläche, die neben einer plausiblen Wolkenmechanik in der Atmosphäre auch eine realistisch wirkende Entwicklung der Vegetation auf der Planetenoberfläche ermöglichen soll. Betreuer: Maximilian Klein Mai 2012

September 2012

|

||||||

|

Bachelorarbeit

Artem Leichter

Leibniz Universität Hannover, DLR Braunschweig

Generierung von 4D Ausweichtrajektorien

Beschreibungstext anzeigen

Bei den aktuellen Planungsverfahren für den Luftverkehr entstehen regelmäßig Situationen, in denen die Flugzeuge die gesetzlich vorgeschriebenen Sicherheitsabstände nicht einhalten können. Diese Unterschreitungen werden als Kollisionen bezeichnet. Es gibt verschiedene Verfahren zur Erkennung von Kollisionen und zur Aulösung von Kollisionssituationen. Diese Verfahren sind wenig integriert und nutzen nicht die Vorteile der modernen Navigationstechnologie (z.B. DG-PS). Die Ausweichtrajektorien werden nicht optimiert. Am DLR (Deutsches Zentrum für Luft- und Raumfahrt) werden die Trajektorien als Teil des 4D-Raumes abgebildet. Der 4D-Raum setzt sich aus den drei Raumdimensionen und der vierten Zeitdimension zusammen. In dieser Arbeit wurde ein Programm entwickelt, das aus einer Menge von übergebenen Trajektorien eine Trajektorie so anpasst, dass keine Konflikte mehr vorhanden sind. Um dieses Ziel zu erreichen, wird ein mit Konflikten behafteter Bereich mit einer generierten Trajektorie überbrückt. Die Generierung der Ausweichtrajektorie geschieht in konsistenter 4D-Planung. Das automatisierte Generieren der Ausweichtrajektorien auf Basis des 4D-Raums erlaubt das Modellieren des Lateral- und Vertikal-Ausweichens. Zusätzlich kann mit Hilfe der Zeitdimension auch das Variieren der Geschwindigkeit zur Vermeidung der Kollision abgebildet werden. Bei der automatischen Generation eröffnet sich die Möglichkeit, die Trajektorie zu optimieren: Zum Beispiel nach solchen Aspekten wie Treibstoffeffizienz oder Flugkomfort für Passagiere. Das entwickelte Programm generiert keine fliegbare Trajektorie, sondern diskretisiert lediglich den Suchraum um den Konfliktbereich und sucht nach einer möglichen Überbrückung für den Konfliktbereich. Als Ergebnis wird eine Liste mit Punkten im 4D-Raum ausgegeben. Diese Liste wird von der DLR-eigenen TrafficSim in eine fliegbare Trajektorie umgewandelt. Bei der Generierung der Ausweichtrajektorie ist zu beachten, dass TrafficSim mit geringerer Anzahl von Punkten bessere fliegbare Trajektorien generiert als bei höherer. Betreuer: [email protected] Mai 2012

September 2012

|

||||||

|

Bachelorarbeit

Felix Haase

Prozedurale Multiskalen-Generierung von Planetenoberflächen

Beschreibungstext anzeigen

Ziel dieser Arbeit ist es Planetenoberflächen prozedural zu generieren. Dazu sollen insbesondere Fraktale verwendet werden die es ermöglichen sollen die Planeten auf verschiedenen Skalen mit unterschiedlichem Detailgrad darzustellen. Die zu entwickelnden Methoden sollen dabei klimatische Unterschiede bei der Generierung berücksichtigen. Neben der prozeduralen Generierung sollen auch verschiedene LOD (Level of Detail) Verfahren untersucht werden, um die Planeten in Echtzeit anzeigen und deren Detailgrad nahtlos anpassen zu können. Betreuer: Maximilian Klein Februar 2012

Juni 2012

|

||||||

|

Bachelorarbeit

Romeo Shuka

Leibniz Universität Hannover

3D-Textursynthese auf Grundlage zweidimensionaler Exemplare

Beschreibungstext anzeigen

Texturen dienen in der Computergrafik der Erzeugung detaillierter Oberflächenstrukturen ohne eine Verfeinerung der zugrundeliegenden Geometrie. 2D Texturen sind dabei oft Fotografien von Oberflächen, die beim Rendern auf die entsprechenden Oberflächen der Szene abgebildet werden. Sie erzeugen eine realistische Anmutung der Oberflächen von Objekten. Schnitte durch Objekte können mit dieser Methode allerdings nur schlecht visualisiert werden, da dies das Vorhandensein von 2D-Fotografien verschiedener Schnittrichtungen voraussetzt. 3D- oder Solid Textures können hier Abhilfe schaffen, da sie Informationen über die Detailstruktur des Inneren von Objekten geben. Sie werden üblicherweise als Voxeldatensatz, d.h. als Skalar- oder Vektorfeld auf einem ortsfesten, meist orthogonalen Raumgitter gespeichert. Moderne Grafikkarten bieten mittlerweile Hardware-Unterstützung für 2D-Texturen, so dass das Problem der Beschaffung von 3D-Texturen in letzter Zeit in den Mittelpunkt wissenschaftlicher Betrachtung gerückt wurde. Es wurden verschiedene funktionale Syntheseverfahren, als auch die Erzeugung auf Grundlage von Exemplaren, also zweidimensionalen Beispielbildern vorgeschlagen (Übersicht in [1]). In dieser Arbeit soll ein fortgeschrittenes Verfahren, z.B. basierend auf der Arbeit von Kopf et al. [2] entwickelt werden. Die Implementation soll in Java oder C++ erfolgen und die entstehenden 3D-Texturen in YaDiV geladen werden können. Speziell sollen als Exemplare Mikroskopien von Dualphasenstählen dienen, auf deren Besonderheiten Rücksicht genommen werden soll. Quellen [1] Pietroni et al. "Solid-Texture Synthesis: A Survey", IEEE Computer Graphics and Applications, 2010. [2] Kopf et al. "Solid Texture Synthesis from 2D Exemplars", ACM Trans. Graph., Vol. 26, No. 3, 2007, p. 2. Betreuer: [email protected] Januar 2012

Mai 2012

|

||||||

|

Bachelorarbeit

Georg Konwisser

Development and Analysis of 2D and 3D Shape Matching and Shape Retrieval Algorithms using Laplace-Beltrami Spectra and Medial Axis Information

Beschreibungstext anzeigen

Written by Georg Konwisser (gekonwi AT gmail.com): Abstract Development of algorithms often focuses on one task: creating an algorithm which is better than another one doing the same task. The developer is thus compelled to answer the question: "Which algorithm is better?" The highly extendable modular framework and application I developed and implemented for this thesis can help developers of any classifying, matching or retrieval algorithms to answer this question with less implementation effort saving development time and cost. Overview In this work I will refer to the mentioned framework and application using the current project name AlCom (Algorithm Comparison). The main outline of this thesis is as follows:

November 2011

März 2012

|

||||||

|

Bachelorarbeit

Nicola Hauke

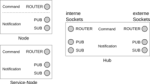

Entwicklung eines modularen Clusterframeworks

Beschreibungstext anzeigen

Ein Großteil der heutigen Anwendungen nutzen die parallele Ausführung von Programmen zum verringern der Rechenzeit. Die Parallelisierung erfolgt dabei meist in feinster Handarbeit und erfordert viel Zeit. Das Ziel dieser Arbeit ist die Erstellung eines Frameworks, dass die Parallelisierung von Programmen einerseits und den eigentlichen Entwicklungsprozess besser unterstüzen soll. Dabei soll das Framework mit einer Share-Nothing Architektur ein stabiles System bieten, dass ohne weiteren Aufwand die einzelnen Programmkomponenten parallel ausführen kann. Dazu soll das System modular gehalten werden, sodass die entwickelten Module leicht für jedermann verwendbar sind. Dafür werden klare Interfaces zur Kommunikation benötigt. Technisch wird das ganze über die ZeroMQ Bibliothek und einer Serialisierungsbibliothek wie Google Protocol Buffers implementiert werden. Dadurch wird es auch möglich sein Module in verschiedenen Programmiersprachen zu schreiben. Betreuer: Maximilian Klein November 2011

März 2012

|

||||||

|

Bachelorarbeit

Karoline Busse

Implementierung einer parallelen partikelbasierten Fluidsimulation

Beschreibungstext anzeigen

Ein gängiges Modell zur Fluidsimulation stellen die Navier-Stokes Gleichungen dar. Diese nicht linearen partiellen Differentialgleichungen lassen sich mittels verschiedener Diskretisierungsmethoden lösen, von denen einige auf Grids oder Dreiecks-Meshs arbeiten. Andere verfolgen einen Partikelansatz, wie die Smoothed Particle Hydrodynamics (SPH) Methode. Das SPH Verfahren bietet dabei im Echtzeitbereich einige Vorteile. Aufgrund der Struktur des SPH Verfahrens ist es möglich interaktive Simulationen zu schaffen die auch visuell ansprechend sind.

Beschreibungstext verbergen

Die Berechnung der kontinuierlichen Parameter im SPH Verfahren geschieht über sogenannte Smoothing Kernels. Diese ermöglichen das effiziente Berechnen des Druckes in jedem Raumpunkt, wenn die Nachbarschaft eines jeden Partikels schnell bestimmt werden kann. Dies geschiet üblicherweise über ein Spacial Hashing mit dem es möglich ist Fluide mit einigen tausend Partikeln zu simulieren. In dieser Arbeit soll, unter der Verwendung von Grafikhardware, die mögliche Anzahl an Partikeln durch Parallelisierungstechniken erhöht werden. Dabei soll die Parallelisierung mit OpenCL umgesetzt werden, um auch mögliche Portierungen auf andere Plattformen zu erleichtern. Betreuer: Maximilian Klein Oktober 2011

Februar 2012

|

||||||

| 2011 | ||||||

|

Bachelorarbeit

Mohammad Ali Azizi-Sales

3D-Textursynthese für die Mikrostrukturmodellierung von Dualphasenstählen anhand von 2D-Metallographie

Beschreibungstext anzeigen

Wachsende Anforderungen im Bereich des Automobilbaus an den Werkstoff Betreuer: [email protected] Juni 2011

Oktober 2011

|

||||||

|

Bachelorarbeit

Sergi Lazaro

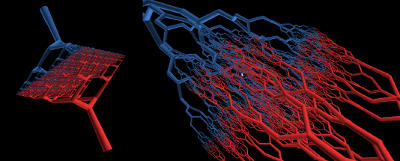

Modelling of realistic Blood Vessel Geometry

Beschreibungstext anzeigen

With modern laser technology it has become possible to print living 3D organic structures like organs or muscles. Currently one of the main problems of this procedure is that the living material dies off during the printing process, therefor it becomes necessary to generate a supply.

The goal of this thesis is to analyse and construct the geometry of blood vessels. A vessel consists of an inner and outer diameter and may branch several times. A special focus will lie on the two end points, which function as input and output of the liquid supply system.

For this it is planned, to construct the basic structure as a connected graph generated by a Lindenmayer System. This graph is then understood as the medial axis of the vessel geometry. The inner and outer vessel diameter define the radius function. For the construction process, it should be possible to tweak these parameters.

Beschreibungstext verbergen

Betreuer: Karl-Ingo Friese Mai 2011

September 2011

|

||||||

|

Bachelorarbeit

Magnus Adler

Leibniz Universität Hannover

Differentielle Wahrnehmungsschwellen in der Haptik

Beschreibungstext anzeigen

Es soll untersucht werden, wie sich die Wiederholrate der haptischen Darstellung auf die Qualität der Wahrnehmung auswirkt. Zu diesem Zweck werden unter Zuhilfename statistischer Methoden aus der Psychophysik Probandenversuche durchgeführt und analysiert.

Beschreibungstext verbergen

Betreuer: Rasmus Buchmann Mai 2011

September 2011

|

||||||

|

Bachelorarbeit

Mona Lepke

Untersuchung zur Form- und Mustererkennung auf LC Displays bei benachbarten Farbwerten

Beschreibungstext anzeigen

In vielen Anwendungen wird Information als Farbwert kodiert. So stellt z.B. eine Wärmekamera Temperaturwerte in einer Falschfarbenskala dar. In der Medizin werden Intensitätswerte oft als Graustufen repräsentiert. Dabei können unterschiedliche physikalische Effekte kodiert werden, bei einem CT Bild stehen die Graustufen für die Schwächung der Röntgenenergie, bei einem MRT Bild für die Kernspinrelaxationszeit. Eine hohe Intensität wird dabei meist als Weiss, eine niedrige als Schwarz dargestellt, benachbarte Intensitäten erhalten ähnliche oder (bedingt durch den eingeschränkten Farbraum) sogar die gleiche Grauwerte.

Beschreibungstext verbergen

Oft übersehen wird dabei die Frage, ob die darstellbaren Farb- oder Grauwerte auch optisch auseinandergehalten werden können. Im DICOM Standard wurden dazu umfangreiche Untersuchungen durchgeführt und für die medizinische Befundung spezielle Monitore und Kalibrierungstechniken gefordert. Wie aber sieht es auf normalen LCD Monitoren aus, die z.B. in der präoperativen Planung verwendet werden? Hier setzt diese Arbeit an, in der Benutzertests zur Form- und Mustererkennung durchgeführt werden sollen. Dabei soll auf den Ergebnissen der Studienarbeit von Lara Toma aufgebaut werden, die ebenfalls am Welfenlab entstanden ist.Betreuer: Karl-Ingo Friese Mai 2011

September 2011

|

||||||

|

Bachelorarbeit

Alexander Lanin

Gestenerkennung mit einem Datenhandschuh

Beschreibungstext anzeigen

Am Institut für Mensch-Maschine-Kommunikation wird aktuell ein Raum für Forschung in Bereich Virtual-Reality ausgestattet. In einer Reihe von studentischen Arbeiten sollen daher kleinere Anwendungen für die einzelnen Komponenten dieses VR-Raums entwickelt werden. Diese sollen in erster Linie für nachfolgende Arbeiten die Verwendung der vorhandenen Programmierschnittstellen demonstrieren. Es soll aber auch die Leistungsfähigkeit der Geräte und vor allem deren Grenzen analysiert Eine dieser Komponenten ist ein Datenhandschuh, der die Gelenkstellungen einer Hand erfassen kann. Mithilfe dieses Geräts soll ein System entwickelt werden, das die Steuerung von Anwendungen durch Gesten ermöglichen soll. Dazu soll im Rahmen dieser Arbeit die Ansteuerung des Datenhandschuhs und dessen Einbindung in ein bestehendes Framework realisiert werden. Die Möglichkeit der Erkennung einfacher Gesten soll dabei aufgezeigt werden. Betreuer: Alexander Vais Januar 2011

Mai 2011

|

||||||

| 2010 | ||||||

|

Bachelorarbeit

Falk Garbsch

Entwicklung einer VR-Umgebung zur Untersuchung der räumlichen Wahrnehmung von multiplen dynamischen Objekten

Beschreibungstext anzeigen

Diese Bachelorarbeit entstand in Zusammenarbeit mit dem Institut für Sportwissenschaft der Leibniz Universität Hannover und beschreibt die Entwicklung einer Applikation zur Darstellung von Szenen für die Durchführung von Wahrnehmungsversuchen. Betreuer: [email protected] September 2009

Januar 2010

|

||||||

| 2009 | ||||||

|

Bachelorarbeit

Maximilian Klein

Numerical Solvers on the Cell B.E. Processor Architectur for Haptic Applications

Beschreibungstext anzeigen

To increase overall performance, parallelisation has become more and

Beschreibungstext verbergen

more important over the last years. Although current PC processors feature more processor cores on per chip, still the floating point performance of the cores is not enough for complex physical simulations at interactive framerates. Lacking such high performance CPUs, IBM has designed a processor closing the gap for scientific applications, named the Cell B.E. Processor. Due to its parallel architecture, it requires a lot of programming efforts to utilise the power. This thesis took the first steps in using this architecture in a cluster environment to accelerate a textile simulation. The IBM featured libraries were tested and an implementation with emphasis on reusability using the physical simuluation framework (SOFA) was made. April 2009

August 2009

|

||||||

|

Bachelorarbeit

Olaf Göllner

Implementierung und Untersuchung numerischer Algorithmen zur physikalischen Simulation auf CUDA-fähigen GPUs

Beschreibungstext anzeigen

Aufgrund der steigenden Rechenleistung heutiger Grafikkarten und der bereits aus bisherigen Arbeiten gewonnenen Erfahrungen am Institut zur Verwendung der GPUs für physikalische Simulationen, soll in dieser Bachelorarbeit die Fähigkeiten des CUDA-Frameworks aufgezeigt werden. Die Aufgabe ist es eine bestehende CPU-basierten Simulation auf dieses Framework und somit auf die GPU zu portieren. Weiterhin soll untersucht werden, welche Vor- und Nachteile sich aus diesem Framework für die Simulation ergeben und welche architektonischen Veränderungen an der Implementation notwendig sind um eine optimale Ausnutzung der Rechenleistung zu erhalten.Die NVIDIA CUDA Architektur ermöglicht die Verwendung neuer Programmierparadigmen für die von ihr unterstützten General-Purpose Graphic Processing Units (GPGPUs). Die vorliegende Arbeit hat das Ziel diese Architektur auf die Berechnung aufwendiger numerischer Echtzeitverfahren zur physikalischen Simulation zu untersuchen. Ein zentraler Aspekt dieser Arbeit ist dabei die Betrachtung und Implementierung konjugierter Gradientenverfahren, welche als Lösungssysteme zur Kräfteberechnung zum Einsatz kommen.

Beschreibungstext verbergen

Januar 2009

Mai 2009

|

||||||

| 2008 | ||||||

|

Bachelorarbeit

Li Li

Konstruktion und Visualisierung dreidimensionaler Voronoi-Diagramme.

März 2008

Mai 2008

|

||||||

| 2007 | ||||||

|

Bachelorarbeit

Alexander Vais

Leibniz Universität Hannover

Eigenwertberechnungen voxelbasierter Daten mittels FEM.

August 2007

|

||||||

|

Bachelorarbeit

Sven Thomas

Leibniz Universität Hannover

Implementation und Untersuchung verschiedener Mesh-Verfeinerungstechniken

Beschreibungstext anzeigen

Die Unterteilung von Flächen, das sogenannte Subdivisioning, ist mittlerweile eine Standardmethode zur Darstellung von glatten Freiformflächen in der Computergrafik. Diese Flächen sind definiert durch eine Abbildung von einem gegeben Kontrollmesh zu einem verfeinerten Mesh, dem Subdivision Operator.

Beschreibungstext verbergen

Da dieser Operator zusätzlich einen speziellen Tiefpass-Filter auf die Punktposition anwendet, liefert er eine Sequenz von Meshes, die zu einer glatten Fläche konvergieren. Durch diese Technik ist es sehr leicht möglich eine überall glatte Freiformfläche zu definieren. Die Gestalt dieser Fläche lässt sich dann bequem durch das Verschieben des Kontrollmeshes verändern ohne komplizierte Randbedingungen wie im Falle von verklebten Patches zu berücksichtigen. In der Arbeit sollen drei verschiedene Subdivision-Operatoren in C++ implementiert werden, die sich sowohl auf die Punkte als auch auf Zusatzdaten anwenden und invertieren lassen. Analysis and Implementation of Different Techniques for Mesh Subdivision Mesh subdivision is a common technique to display free-form surfaces. Based on a coarse triangular mesh, additional points can be calculated to get a finer and smoother representation of the surface. In the first part of this work these three techniques are described and compared concerning the runtime and the visual results. With regard to the HAPTEX project an adaptive version of the Butterfly scheme is presented to be able to subdivide a mesh only at positions where high detail is necessary. Using this implementation, triangle meshes can be refined and simplified at any time at arbitrary positions. In addition to the geometrical values, also further properties can be computed for new points added during refinement. Juli 2007

|

||||||

|

Bachelorarbeit

Branko Petkovic

Leibniz Universität Hannover

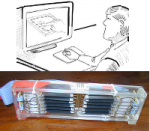

Darstellung von feinen Höhenprofilen mit einem taktilen Display

Beschreibungstext anzeigen

Virtuelle Realität ist die Darstellung der Wirklichkeit und ihrer physikalischen Eigenschaften in einer in Echtzeit computergenerierten virtuellen Umgebung. Neben der optischen und akustischen Wahrnehmung kann auch die taktile Wahrnehmung in der virtuellen Umgebung ermöglicht werden. Unter taktiler Wahrnehmung wird das Erkennen von Druck, Berührung und Vibrationen auf der Haut verstanden. Im Gegensatz zur haptischen Interaktion mit virtuellen Gegenständen über Kraftrückkopplungssysteme wurde die taktile Simulation feiner Oberflächenstrukturen bisher wenig erforscht. Am Lehrstuhl für Graphische Datenverarbeitung wurden verschiedene Experimente mit einem taktilen Display (siehe Bild) durchgeführt. In dieser Arbeit soll ein weiterer Algorithmus zur taktilen Simulation von Oberflächenstrukturen untersucht werden. Dazu ist es unter anderem notwendig, die Firmware des taktilen Displays anzupassen. Betreuer: [email protected] Juni 2007

|

||||||

|

Bachelorarbeit

Marcus Rieche

Leibniz Universität Hannover

OpenSG - Verteilte Visualisierung in verschiedenen Anwendungsszenarien

Beschreibungstext anzeigen

Die 3D Grafikhardware hat gerade bei Stanard PCs in den letzten Jahren große Fortschritte gemacht. Dennoch gibt es auch heute noch Grenzen, z.B. bei der Visualisierung großer Voxel-Daten aus dem medizinischen Bereich. Abhilfe schaffen entweder teure Spezialcomputer (Graphic Workstations) oder ein verteilter Ansatz, auch Clustering genannt.

Beschreibungstext verbergen

Betreuer: Karl-Ingo Friese Februar 2007

Juni 2007

|

||||||

|

Bachelorarbeit

Maximilian Müller

Leibniz Universität Hannover

Simulation des Greifvorgangs von starren Körpern am GRAB-Device

Beschreibungstext anzeigen

In the recent years the visual illusion of virtual reality systems has reached a convincing level. But a more important factor, the interaction with the virtual environment, is still far away from being natural. Thus research groups investigate methods to enrich interaction by adding the haptic modality. Mai 2007

|

||||||

|

Bachelorarbeit

Daniel Pralle

Leibniz Universität Hannover

Numerische Berechnungen auf Grafikkarten.

April 2007

|

||||||

|

Bachelorarbeit

Yasin Alakese

Leibniz Universität Hannover

Eine taktile Benutzerschnittstelle für blinde Computernutzer

Beschreibungstext anzeigen

Durch die fortschreitende Verbesserung der grafischen Darstellung am Computer wird die Informationsaufnahme zwar für sehende Personen erleichtert, für blinde Computernutzer wirkt sich dies aber eher zum Nachteil aus. So sind etwa Webseiten für Blinde nur dann richtig nutzbar, wenn diese entsprechend gestaltet wurden. Eine Verbesserung könnte sich aus der Darstellung des Bildschirminhalts mit Hilfe eines taktilen Displays ergeben. Es soll ein System entwickelt werden, das den Bildschirminhalt mit Hilfe eines taktilen Displays erfühlbar macht. Der Nutzen dieses Systems soll in Versuchen untersucht werden.

Beschreibungstext verbergen

Betreuer: [email protected] März 2007

|

||||||

| 2006 | ||||||

|

Bachelorarbeit

Karsten Vogt

Leibniz Universität Hannover

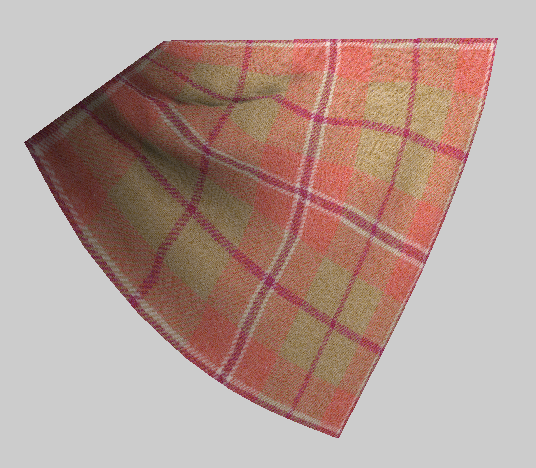

Entwicklung eines Verfahrens zur Realzeit-Simulation von Textilien unter Verwendung von progressiven Meshs

Beschreibungstext anzeigen

Unter den populären Verfahren der Textilsimulation gibt es viele Ansätze, die in Echtzeit glaubwürdige Ergebnisse liefern. Diese Verfahren verwenden jedoch keine echten Messdaten zur Beschreibung des Textilverhaltens. Dagegen sind Verfahren, die mit realen Messdaten arbeiten, in der Regel nicht echtzeitfähig.

Für die spätere Verwendung im HAPTEX Projekt (HAPtic sensing of virtual TEXtiles) soll deshalb ein Verfahren entwickelt werden, das Textilien in einer virtuellen Umgebung visualisiert und eine haptischen Interaktion auf einem handelsüblichen Personal Computer ermöglicht. Entscheidend ist, dass die nachgebildeten Textilien nicht nur den optischen, sondern auch den haptischen Erwartungen entsprechen.

Unter den populären Verfahren der Textilsimulation gibt es viele Ansätze, die in Echtzeit glaubwürdige Ergebnisse liefern. Diese Verfahren verwenden jedoch keine echten Messdaten zur Beschreibung des Textilverhaltens. Dagegen sind Verfahren, die mit realen Messdaten arbeiten, in der Regel nicht echtzeitfähig.

Für die spätere Verwendung im HAPTEX Projekt (HAPtic sensing of virtual TEXtiles) soll deshalb ein Verfahren entwickelt werden, das Textilien in einer virtuellen Umgebung visualisiert und eine haptischen Interaktion auf einem handelsüblichen Personal Computer ermöglicht. Entscheidend ist, dass die nachgebildeten Textilien nicht nur den optischen, sondern auch den haptischen Erwartungen entsprechen.September 2006

|

||||||

|

Bachelorarbeit

Tomasz Bujalski

Leibniz Universität Hannover

Effiziente globale Verfeinerung von Tetraeder-Netzen.

Juni 2006

|

||||||

| 2005 | ||||||

|

Bachelorarbeit

Richard Guercke

Leibniz Universität Hannover

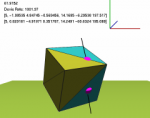

Auffinden ähnlicher Flächen durch den Laplace-Beltrami-Operator

Beschreibungstext anzeigen

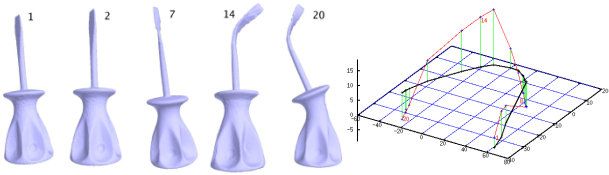

Die beiden obigen Bilder zeigen Zwischenstufen der Verformung des 3d-Modells eines Schraubenziehers und die Entwicklung der zugehörigen Spektra (projiziert in den dreidimensionalen Raum).

Das Problem, eine leicht verformte und eventuell auf verschiedene Weise dargestellte (Bezier-, B-Spline-Darstellung, trianguliert,...) oder umparametrisierte Fläche in einer Sammlung von Flächen wiederzufinden, hat insbesondere im Zusammenhang mit Patentrechtsverletzungen oder bei der Identifikation von Objekten eine wichtige Bedeutung. Aufgrund der Vielzahl der möglichen Darstellungsformen und Parametrisierungen ist dieses Problem ohne aufwendige Vorbereitungsschritte nur schwer lösbar.

Die Berechnung der Eigenwerte des Laplace-Beltrami-Operators bildet eine Fläche auf eine Menge von Zahlen ab, wobei hier nur die ersten (kleinsten) k - typischerweise 50 bis 500 - Eigenwerte benutzt werden.

Die beiden obigen Bilder zeigen Zwischenstufen der Verformung des 3d-Modells eines Schraubenziehers und die Entwicklung der zugehörigen Spektra (projiziert in den dreidimensionalen Raum).

Das Problem, eine leicht verformte und eventuell auf verschiedene Weise dargestellte (Bezier-, B-Spline-Darstellung, trianguliert,...) oder umparametrisierte Fläche in einer Sammlung von Flächen wiederzufinden, hat insbesondere im Zusammenhang mit Patentrechtsverletzungen oder bei der Identifikation von Objekten eine wichtige Bedeutung. Aufgrund der Vielzahl der möglichen Darstellungsformen und Parametrisierungen ist dieses Problem ohne aufwendige Vorbereitungsschritte nur schwer lösbar.

Die Berechnung der Eigenwerte des Laplace-Beltrami-Operators bildet eine Fläche auf eine Menge von Zahlen ab, wobei hier nur die ersten (kleinsten) k - typischerweise 50 bis 500 - Eigenwerte benutzt werden.Diese Zahlen lassen sich als die Frequenzen der Eigenschwingungen des betreffenden Objektes interpretieren. Dieser (materialunabhängige) "Ton" bei der Anregung eines Objektes zu einer Eigenschwingung dient als "Fingerabdruck" für die Fläche, anhand dessen Flächen auf Ähnlichkeit geprüft und in Sammlungen eingeordnet werden können. Theoretische Überlegungen und praktische Versuche zeigen, dass der Abstand zwischen den k-dimensionalen Punkten, die durch die (aufsteigend sortierten) ersten k Eigenwerte beschrieben werden, ein sinnvolles Maß für die Ähnlichkeit der zugehörigen Flächen ist. So lässt sich die Suche nach ähnlichen Flächen in einer Sammlung auf die Suche nach nächsten Nachbarn von Punkten im k-dimensionalen Raum zurückführen. In dieser Arbeit wurden einerseits weitere Untersuchungen zur Entwicklung der Laplace-Spektra bei der Verformung von Objekten angestellt und andererseits verschiedene Versuche zum Informationsverlust bei der Anwendung der Principal Component Analysis (Projektion der hochdimensionalen Punkte auf die Achsen ihrer größten Varianz) auf Mengen von Spektra zur Verringerung der Dimensionalität durchgeführt. September 2005

|

||||||

|

Bachelorarbeit

Andreas Borowski

Leibniz Universität Hannover

Implementierung des Buchberger-Algorithmus als Vorstufe zum Lösen multiaffiner Gleichungssysteme

Beschreibungstext anzeigen

In vielen Bereichen der Mathematik und der Ingenieurswissenschaften tauchen Probleme auf, die das Lösen von Polynomgleichungen in mehreren Variablen erfordern. Also im Allgemeinen Gleichungen der Form:

In vielen Bereichen der Mathematik und der Ingenieurswissenschaften tauchen Probleme auf, die das Lösen von Polynomgleichungen in mehreren Variablen erfordern. Also im Allgemeinen Gleichungen der Form:

f1(x1, x2, . . . , xn) = 0Eine bekannte Möglichkeit solche Gleichungen zu lösen ist zunächst die Methode der Gröbnerbasen anzuwenden um die Gleichungen algebraisch zu vereinfachen, und anschließend numerische Verfahren zu verwenden. Der für die algebraische Umformung verwendete Algorithmus ist der Buchberger-Algorithmus. Dieser wurde 1965 von Buchberger eingeführt. Die von diesem Algorithmus berechneten Gröbnerbasen sind von zentraler Bedeutung im Bereich der Computeralgebra, so dass er in allen gängigen Computeralgebrasystemen, wie Maple, MuPAD, oder Mathematica implementiert ist. Ziel dieser Arbeit ist, den Buchberger-Algorithmus zu implementieren und zum Lösen von Gleichungen obiger Form zu verwenden. Mai 2005

|

||||||

|

Bachelorarbeit

Daniela Lauer

Leibniz Universität Hannover

Zerlegung polygonal berandeter Gebiete in der euklidischen Ebene in konvexe Teilbereiche

Beschreibungstext anzeigen

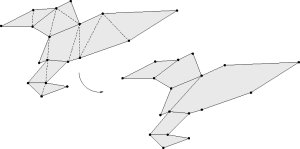

In der Computergrafik werden möglichst einfache Darstellungen verwendet um geometrische Objekte zu modellieren. Eine gängige Methode ist es ein Objekt durch die Approximation seiner Oberfläche darzustellen. Dabei wird diese aus einer Menge planarer Vielecke,

hier Polygone genannt, zusammengesetzt. Damit auch komplexe Objekte effektiv verwaltet und bearbeitet werden können, wird jedoch noch eine einfachere Darstellung der Teilstücke benötigt. Eine Möglichkeit ist, Polygone als die Vereinigung von weniger komplexen Teilstücken zu repräsentieren. Ein konvex zerlegtes Polygon setzt sich nur aus konvexen Teilstücken (einfacheren Polygonen) zusammen.

Die Motivation für die vorliegende Arbeit kommt aus der Computergrafik aus dem Gebiet wissenschaftliche Visualisierung mit Spiele-Engines. Für eine optisch anspruchsvolle Visualisierung in Echtzeit wird unter anderem eine leistungsstarke Renderingsoftware benötigt. Eine günstige Alternative zu kommerziellen Produkten wie z.B. 3D Studio MAX oder Autocad bieten Spiele-Engines. Im Gegensatz zu den Anfängen der Computergrafik sind heute die Hersteller von animierten Filmen und Computerspielen führend im Bereich der Echtzeit 3D-Visualisierung.

Deshalb wird am Lehrstuhl Graphische Datenverarbeitung, Institut für Mensch-Maschine-Kommunikation der Leibniz Universität Hannover, die Eignung von Spieleengines für die Visualisierung wissenschaftlicher Daten anhand einiger Beispiele (Sarnow: Quake 3, Hanel: Unreal 2) erprobt. Die von einem Laserscanner gemessene Punktwolke der Höhlenwände wurde in Diplomarbeiten (Farajollahi, Friese,) in eine triangulierte Darstellung überführt und dient als Datenquelle für diese Untersuchungen. Erste Ergebnisse ermöglichen ein flüssiges Durchwandern der Höhle. In der Darstellung mit der Quake-Engine führte jedoch beispielsweise das Hinzufügen von aufwändigen Lichteffekten zu Performanceverlusten. Dies liegt unter anderem an der Menge der darzustellende Polygone (bislang Dreiecke). Die Quake Engine ist jedoch in der Lage, nicht nur Dreiecke, sondern konvexe Polygone einzulesen und zu verarbeiten. Dies eröffnet die Möglichkeit, durch das Verwenden größerer konvexer Teilstücke mit möglichst wenig Detailverlust die Anzahl der Polygone zu reduzieren.

Die Idee liegt also nahe, nach großen planaren oder quasiplanaren Teilgebieten bestehend aus mehreren Dreiecken zu suchen, um diese dann als Vereinigung einer Menge von konvexen Polygonen darzustellen. Es wird also ein Algorithmus benötigt, der ein in triangulierter Form vorliegendes Gebiet (Polygone) in möglichst wenige konvexe Teilstücke zerlegt.

In der Computergrafik werden möglichst einfache Darstellungen verwendet um geometrische Objekte zu modellieren. Eine gängige Methode ist es ein Objekt durch die Approximation seiner Oberfläche darzustellen. Dabei wird diese aus einer Menge planarer Vielecke,

hier Polygone genannt, zusammengesetzt. Damit auch komplexe Objekte effektiv verwaltet und bearbeitet werden können, wird jedoch noch eine einfachere Darstellung der Teilstücke benötigt. Eine Möglichkeit ist, Polygone als die Vereinigung von weniger komplexen Teilstücken zu repräsentieren. Ein konvex zerlegtes Polygon setzt sich nur aus konvexen Teilstücken (einfacheren Polygonen) zusammen.

Die Motivation für die vorliegende Arbeit kommt aus der Computergrafik aus dem Gebiet wissenschaftliche Visualisierung mit Spiele-Engines. Für eine optisch anspruchsvolle Visualisierung in Echtzeit wird unter anderem eine leistungsstarke Renderingsoftware benötigt. Eine günstige Alternative zu kommerziellen Produkten wie z.B. 3D Studio MAX oder Autocad bieten Spiele-Engines. Im Gegensatz zu den Anfängen der Computergrafik sind heute die Hersteller von animierten Filmen und Computerspielen führend im Bereich der Echtzeit 3D-Visualisierung.

Deshalb wird am Lehrstuhl Graphische Datenverarbeitung, Institut für Mensch-Maschine-Kommunikation der Leibniz Universität Hannover, die Eignung von Spieleengines für die Visualisierung wissenschaftlicher Daten anhand einiger Beispiele (Sarnow: Quake 3, Hanel: Unreal 2) erprobt. Die von einem Laserscanner gemessene Punktwolke der Höhlenwände wurde in Diplomarbeiten (Farajollahi, Friese,) in eine triangulierte Darstellung überführt und dient als Datenquelle für diese Untersuchungen. Erste Ergebnisse ermöglichen ein flüssiges Durchwandern der Höhle. In der Darstellung mit der Quake-Engine führte jedoch beispielsweise das Hinzufügen von aufwändigen Lichteffekten zu Performanceverlusten. Dies liegt unter anderem an der Menge der darzustellende Polygone (bislang Dreiecke). Die Quake Engine ist jedoch in der Lage, nicht nur Dreiecke, sondern konvexe Polygone einzulesen und zu verarbeiten. Dies eröffnet die Möglichkeit, durch das Verwenden größerer konvexer Teilstücke mit möglichst wenig Detailverlust die Anzahl der Polygone zu reduzieren.

Die Idee liegt also nahe, nach großen planaren oder quasiplanaren Teilgebieten bestehend aus mehreren Dreiecken zu suchen, um diese dann als Vereinigung einer Menge von konvexen Polygonen darzustellen. Es wird also ein Algorithmus benötigt, der ein in triangulierter Form vorliegendes Gebiet (Polygone) in möglichst wenige konvexe Teilstücke zerlegt.Betreuer: Karl-Ingo Friese Januar 2005

|

||||||

| 2004 | ||||||

|

Bachelorarbeit

Daniel Scholz

Leibniz Universität Hannover

Triangulation on Parametrized Surfaces

Beschreibungstext anzeigen

The triangulation of parametrized surfaces is a difficult and important step towards FEM calculations and visualization of the surface. Therefore the triangles have to fulfill certain constraints.

The difficulty lies in creating the triangles in parametric space, such that the mapped triangles on the (curved) surface offer the desired qualities. For further quality improvements, a Laplace smoothing can be applied to the triangles vertices.

The triangulation of parametrized surfaces is a difficult and important step towards FEM calculations and visualization of the surface. Therefore the triangles have to fulfill certain constraints.

The difficulty lies in creating the triangles in parametric space, such that the mapped triangles on the (curved) surface offer the desired qualities. For further quality improvements, a Laplace smoothing can be applied to the triangles vertices.Dezember 2004

|

||||||

|

Bachelorarbeit

Cem Dogan

Leibniz Universität Hannover

Perceptual Audio Coding Using Wavelet Packet Analysis

Beschreibungstext anzeigen

A perceptual audio coder analyzing each audio segment adaptively using a best wavelet basis according to the time-varying characteristics of the audio signal has been constructed. The adaptive wavelet packet tree is obtained minimizing a perceptual cost function implementing a masking model mimicking the human auditory system. The resulting scheme is a variable bit-rate audio coder providing compression ratios comparable to MPEG-I layers 1 and 2 with almost transparent quality. A short overview of the structure of the audio coder will be given.

Beschreibungstext verbergen

Dezember 2004

|

||||||

|

Bachelorarbeit

Michael Hanel

Leibniz Universität Hannover

3D-Visualisierung mit Hilfe von Spiel-Engines unter Berücksichtigung erweiterter Texturierungsmöglichkeiten

Beschreibungstext anzeigen

Nowadays, the graphical (re)presentation of several computer-based applications becomes more important, especially in the entertainment electronics sector.

With the Unreal Engine 2 and the associated application Unreal Tournament 2004, the user has the possibility to change some parameters of the engine (so called Modifications) and to create his own maps.

Nowadays, the graphical (re)presentation of several computer-based applications becomes more important, especially in the entertainment electronics sector.

With the Unreal Engine 2 and the associated application Unreal Tournament 2004, the user has the possibility to change some parameters of the engine (so called Modifications) and to create his own maps.

If we try to use the Unreal Engine 2 to visualize scientific data (e.g. a scatter-plot of a cave obtained from a laser measurement), the problem of how the data has to be formatted, so that the engine is able to read it, arises. In this Bachelor-thesis, the approach of representing scientific data with the Unreal Engine 2 as realistic as possible is being accomplished. Betreuer: Karl-Ingo Friese Dezember 2004

|

||||||

| 2003 | ||||||

|

Bachelorarbeit

Sebastian Intas

Leibniz Universität Hannover

Polygonextraktion aus Schwarz-/Weiß-Bildern.

November 2003

|

||||||

|

Bachelorarbeit

Mathias Fiedler

Leibniz Universität Hannover

Automatisierung eines Verfahrens zur Zerlegung von Polygonen in singuläre Elemente

Beschreibungstext anzeigen

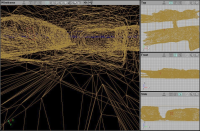

Bei diesem Projekt wurde ein geschlossener 2d-Polygonzug automatisch in Teilgebiete zerlegt, die gewissen Bedingungen genügen. Dazu wurde ein Meshgenerator in C++ zu einer bestehenden Polygon-Klasse zugefügt.

Das Verfahren zur Generierung ist bereits bekannt und wird benötigt um spezielle Schwingungsberechnungen auf ebenen Polygonen durchzuführen.

Bei diesem Projekt wurde ein geschlossener 2d-Polygonzug automatisch in Teilgebiete zerlegt, die gewissen Bedingungen genügen. Dazu wurde ein Meshgenerator in C++ zu einer bestehenden Polygon-Klasse zugefügt.

Das Verfahren zur Generierung ist bereits bekannt und wird benötigt um spezielle Schwingungsberechnungen auf ebenen Polygonen durchzuführen.Oktober 2003

|

||||||

|

Bachelorarbeit

Przemislaw Dul

Leibniz Universität Hannover

XML-Marshalling für C++-Datenstrukturen

Beschreibungstext anzeigen

Das Fachgebiet Graphische Datenverarbeitung verwendet mehrere Datenformate nebeneinander, durch die Weiterentwicklung der Projekte kommen immer wieder neue Datenformate hinzu.

Um eine weitere Divergenz zu verhindern, bietet sich eine auf XML basierende Struktur an. Es wurde ein C++-Modul entwickelt, das den bereits bestehenden, sowie den in Zukunft noch zu implementierenden Klassen ein einfaches Interface bietet, um Daten ihrer Instanzen in ein XML-Dokument zu schreiben und aus diesem wieder zu lesen.

Die Technik, C++-(oder Java-) Datenstrukturen in einem XML-Format zu repräsentieren, wird als Marshalling bezeichnet. Der eigentliche Zweck des Marshallings ist die Übertragung von Objekten in einem Netzwerk, in diesem Projekt wird Marshalling als eine mächtigere Form der Serialisierung verwendet, Objekte als XML-Dokumente zu speichern und zu einem späteren Zeitpunkt wieder aufzunehmen.

Beschreibungstext verbergen

September 2003

|